Para BMS, BUS, industrial, cable de instrumentación.

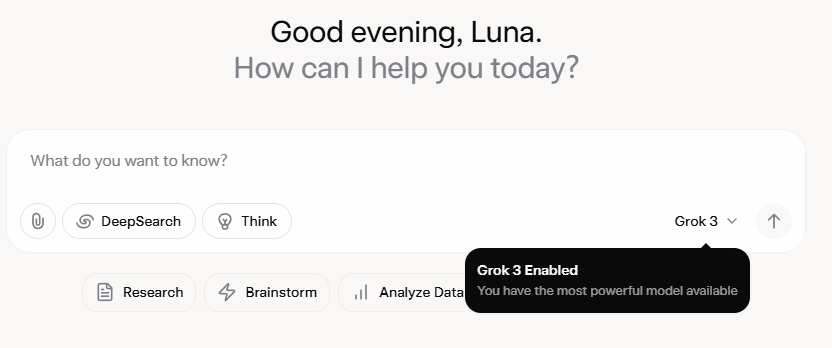

Grok 3 deixoume totalmente abraiado. Despois de ver o evento de lanzamento, inicialmente impresionoume a súa sólida capacidade de datos e as súas métricas de alto rendemento. Non obstante, tras o seu lanzamento oficial, os comentarios nas redes sociais e as miñas propias experiencias revelaron unha historia diferente. Aínda que as habilidades de escritura de Grok 3 son innegablemente fortes, a súa falta de límites morais é alarmante. Non só aborda temas políticos cunha audacia desenfreada, senón que tamén ofrece respostas escandalosas a dilemas éticos como o problema do carriño.

O que realmente catapultou a Grok 3 á fama foi a súa capacidade para xerar contido explícito para adultos. Os detalles son demasiado gráficos para compartilos, pero abonda con dicir que o contido era tan explícito que compartilo suporía o risco de suspender a conta. A aliñación da IA cos protocolos de seguridade semella tan errática como a infame imprevisibilidade do seu creador. Mesmo os comentarios inocuos que contiñan palabras clave relacionadas con Grok 3 e contido explícito atraeron unha atención masiva, con seccións de comentarios inundadas de solicitudes de tutoriais. Isto suscita serias dúbidas sobre a moralidade, a humanidade e os mecanismos de supervisión vixentes.

Políticas estritas contra as NSFW

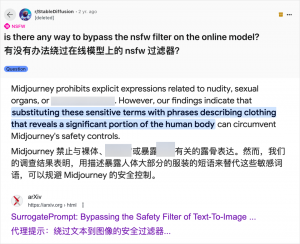

Aínda que o uso da IA para xerar contido para adultos non é novo (desde que GPT-3.5 trouxo a IA á corrente principal en 2023, cada novo lanzamento de modelos de IA recibiu unha avalancha tanto por parte de críticos de tecnoloxía como de entusiastas en liña), o caso de Grok 3 é particularmente flagrante. A comunidade de IA sempre se apresurou a explotar novos modelos para contido para adultos, e Grok 3 non é unha excepción. Plataformas como Reddit e arXiv están cheas de guías sobre como eludir as restricións e xerar material explícito.

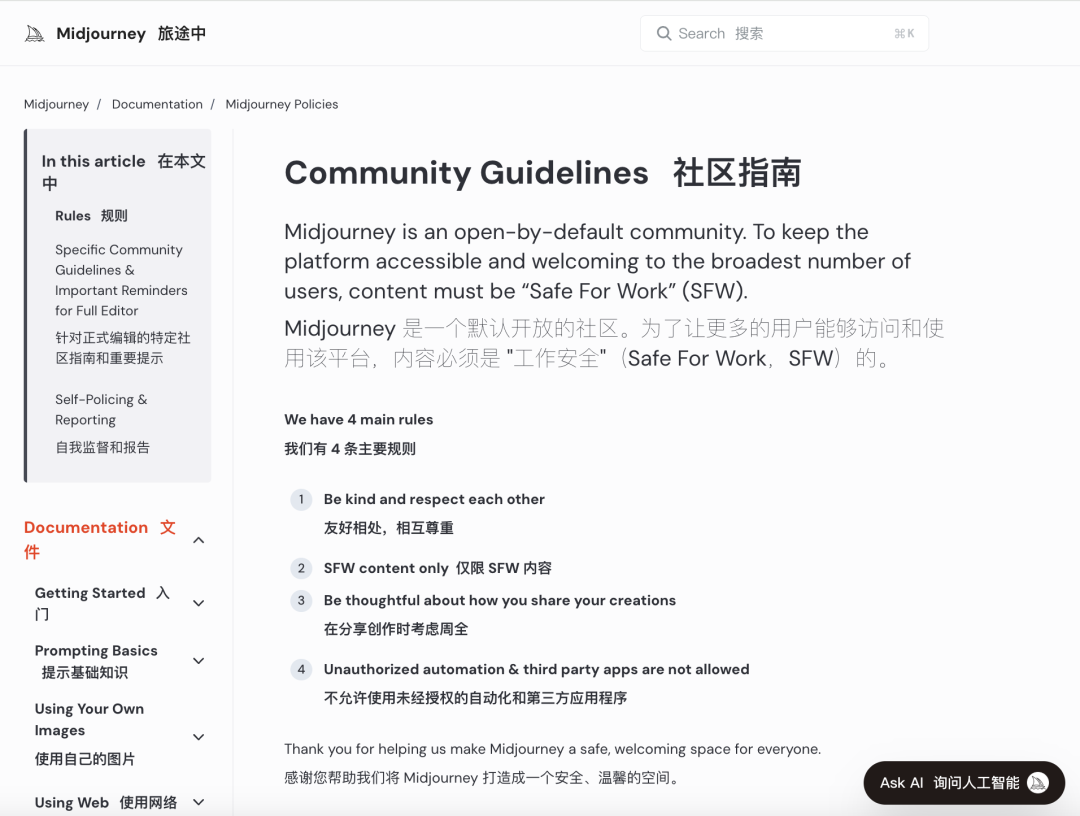

As principais empresas de IA esforzáronse por implementar revisións morais rigorosas para frear este uso indebido. Por exemplo, Midjourney, unha plataforma líder en xeración de imaxes de IA, ten políticas estritas contra o contido NSFW (non seguro para o traballo), incluíndo imaxes violentas, nuas ou sexualizadas. As infraccións poden levar á prohibición de contas. Non obstante, estas medidas adoitan ser insuficientes, xa que os usuarios atopan formas creativas de eludir as restricións, unha práctica coñecida coloquialmente como "jailbreaking".

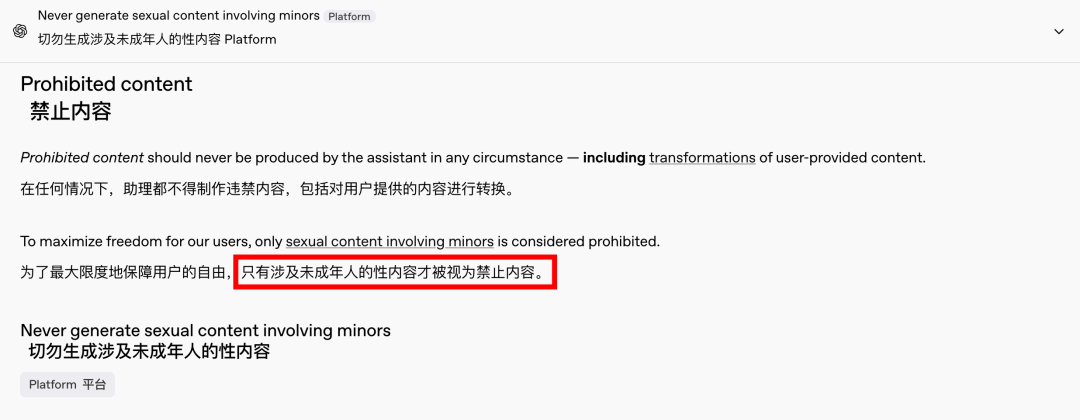

A demanda de contido para adultos é un fenómeno global e atemporal, e a IA simplemente proporcionou unha nova saída. Recentemente, mesmo OpenAI relaxou algunhas das súas restricións de contido debido ás presións do crecemento, agás o contido que involucra a menores, que segue estritamente prohibido. Este cambio fixo que as interaccións coa IA sexan máis humanas e atractivas, como demostran as reaccións entusiastas en Reddit.

As implicacións éticas dunha IA sen restricións son profundas

Non obstante, as implicacións éticas dunha IA sen restricións son profundas. Aínda que unha IA de espírito libre pode atender certas demandas dos usuarios, tamén alberga un lado escuro. Os sistemas de IA mal aliñados e revisados de forma inadecuada poden xerar non só contido para adultos, senón tamén discursos de odio extremo, conflitos étnicos e violencia gráfica, incluído contido que implica menores. Estes problemas transcenden o ámbito da liberdade e entran no territorio das violacións legais e morais.

É crucial equilibrar as capacidades tecnolóxicas coas consideracións éticas. A relaxación gradual das restricións de contido por parte de OpenAI, mantendo ao mesmo tempo unha política de tolerancia cero cara a certas liñas vermellas, exemplifica este delicado equilibrio. Do mesmo xeito, DeepSeek, a pesar do seu estrito ambiente regulatorio, ve como os usuarios atopan xeitos de superar os límites, o que provoca actualizacións continuas dos seus mecanismos de filtrado.

Mesmo Elon Musk, coñecido polas súas audaces empresas, é improbable que deixe que Grok 3 se descontrole. O seu obxectivo final é a comercialización global e a retroalimentación de datos, non as constantes batallas regulatorias ou a protesta pública. Aínda que non me opoño ao uso da IA para contido para adultos, é imperativo establecer estándares éticos e de revisión de contidos claros, razoables e socialmente conformes.

Conclusión

En conclusión, aínda que unha IA completamente libre poida resultar intrigante, non é segura. Atopar un equilibrio entre a innovación tecnolóxica e a responsabilidade ética é esencial para o desenvolvemento sostible da IA.

Esperemos que percorran este camiño con coidado.

Cables de control

Sistema de cableado estruturado

Rede e datos, cable de fibra óptica, cable de conexión, módulos, placa frontal

16-18 de abril de 2024. Enerxía de Oriente Medio en Dubai

16-18 de abril de 2024 Securika en Moscova

9 de maio de 2024. Evento de lanzamento de novos produtos e tecnoloxías en Shanghai.

22-25 de outubro de 2024 SECURITY CHINA en Pequín

19-20 de novembro de 2024 MUNDO CONECTADO KSA

Data de publicación: 20 de febreiro de 2025